递归神经网络

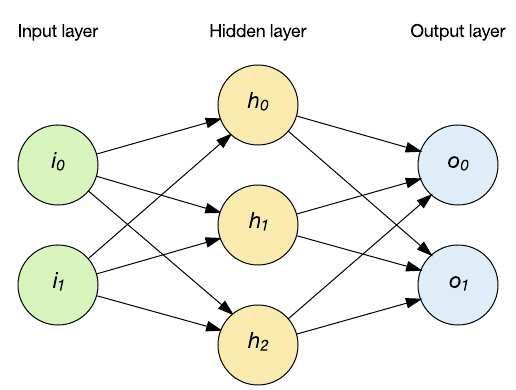

编辑递归神经网络(RNN)是一类神经网络,其中节点之间的连接形成一个有向图沿时间序列。这使其具有时间动态行为。RNN源自前馈神经网络,可以使用其内部状态(内存)来处理可变长度的输入序列。这使它们适用于诸如未分段的连接手写识别[4]或语音识别之类的任务。

不加区别地使用术语“递归神经网络”来指代具有相似一般结构的两大类网络,其中一类是有限冲量,另一类是无限冲量。这两类网络都表现出时间动态行为。有限脉冲递归网络是有向无环图,可以展开并用严格的前馈神经网络代替,而无限脉冲递归网络是不能展开的有向环图。

有限脉冲和无限脉冲递归网络都可以具有其他存储状态,并且该存储可以在神经网络的直接控制下。如果包含时间延迟或具有反馈回路,则存储也可以由另一个网络或图形代替。这样的受控状态被称为门控状态或门控存储器,并且是长短期存储网络(LSTM)和门控循环单元的一部分。这也称为反馈神经网络(FNN)。

独立地RNN(IndRNN)

编辑独立递归神经网络(IndRNN)解决了传统的全连接RNN中的梯度消失和爆炸问题。一层中的每个神经元仅接收其自身过去的状态作为上下文信息(而不是与该层中所有其他神经元的完全连通性),因此神经元彼此独立。可以调节梯度反向传播以避免梯度消失和爆炸,以保持长期或短期记忆。跨神经元信息将在下一层中探讨。IndRNN可以使用非饱和非线性函数(例如ReLU)进行稳健的训练。使用跳过连接,可以训练深度网络。

递归

编辑通过以拓扑顺序遍历结构,在可微分的图样结构上递归应用相同的权重集,从而创建了一个递归神经网络。通常还通过自动区分的反向模式来训练此类网络。他们可以处理结构的分布式表示形式,例如逻辑项。递归神经网络的一种特殊情况是RNN,其结构对应于线性链。递归神经网络已应用于自然语言处理。递归神经张量网络对树中的所有节点使用基于张量的合成函数。

门控循环单元

编辑门控递归单元(GRU)是2014年引入的递归神经网络的门控机制。它们以完整形式和几种简化的变体形式使用。他们在和弦音乐建模和语音信号建模上的表现与长期短期记忆相似。由于缺少输出门,因此它们的参数比LSTM少。

双向

编辑双向RNN使用有限序列根据元素的过去和将来上下文预测或标记序列中的每个元素。这是通过串联两个RNN的输出来完成的,一个处理从左到右的顺序,另一个处理从右到左的顺序。组合的输出是教师给定目标信号的预测。与LSTM RNN结合使用时,已证明该技术特别有用。

相关字段和模型

编辑RNN可能行为混乱。在这种情况下,可以将动力学系统理论用于分析。

它们实际上是具有特定结构的递归神经网络:线性链的结构。递归神经网络在任何层次结构上运行,将子代表示合并为父代表示,而递归神经网络在时间的线性进程上运行,将前一时间步长和隐藏表示合并为当前时间步长。

特别是,RNN可以作为有限冲激响应和无限冲激响应滤波器的非线性形式出现,也可以作为非线性自回归外生模型(NARX)出现。

内容由匿名用户提供,本内容不代表vibaike.com立场,内容投诉举报请联系vibaike.com客服。如若转载,请注明出处:https://vibaike.com/115376/