卷积神经网络

编辑在深度学习中,卷积神经网络(CNN,或ConvNet)是一类人工神经网络(ANN),最常用于分析视觉图像。CNN也被称为移位不变或空间不变的人工神经网络(SIANN),基于卷积核或过滤器的共享权重架构,沿着输入特征滑动并提供称为特征图的平移不变的响应。与直觉相反的是,大多数卷积神经网络对翻译不具不变性,因为它们对输入进行了降采样操作。它们在图像和视频识别、推荐系统、图像分类、图像分割、医学图像分析、自然语言处理、脑机接口和金融时间序列中都有应用。CNN是多层感知器的规范化版本。多层感知器通常意味着完全连接的网络,也就是说,一层的每个神经元都与下一层的所有神经元相连。这些网络的全连接性使它们很容易过度拟合数据。典型的正则化或防止过拟合的方法包括:在训练过程中惩罚参数(如权重衰减)或修剪连接性(跳过的连接、辍学等)。CNN对正则化采取了不同的方法:它们利用数据中的层次模式,并利用压印在其过滤器中的较小和较简单的模式组装出越来越复杂的模式。因此,在连接性和复杂性的尺度上,CNN处于较低的极端。卷积网络受到生物过程的启发,因为神经元之间的连接模式类似于动物视觉皮层的组织。单个皮层神经元只对视野中被称为感受野的有限区域的刺激做出反应。不同神经元的感受野部分重叠,使其覆盖整个视野。与其他图像分类算法相比,CNN使用的预处理方法相对较少。这意味着网络通过自动学习来优化过滤器(或内核),而在传统算法中,这些过滤器是手工设计的。这种独立于先验知识和人工干预的特征提取是一个主要优势。

卷积神经网络的定义

编辑卷积神经网络是一种专门的人工神经网络,它使用一种叫做卷积的数学运算来代替其至少一个层中的一般矩阵乘法。它们被专门设计用来处理像素数据,并被用于图像识别和处理。

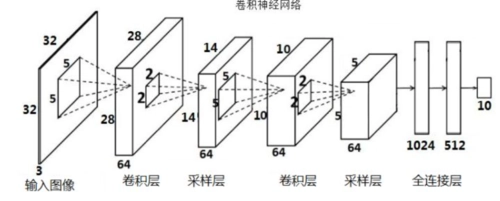

卷积神经网络的架构

编辑卷积神经网络由一个输入层、隐藏层和输出层组成。在任何前馈神经网络中,任何中间层都被称为隐藏层,因为它们的输入和输出被激活函数和最终卷积所掩盖。在卷积神经网络中,隐藏层包括执行卷积的层。通常,这包括一个执行卷积核与该层输入矩阵的点积的层。这个积通常是Frobenius内积,其激活函数通常是ReLU。当卷积核沿着该层的输入矩阵滑动时,卷积操作产生了一个特征图,这反过来又有助于下一层的输入。随后是其他层,如池化层、全连接层和归一化层。

卷积层

编辑在CNN中,输入是一个张量,其形状为:(输入数量)×(输入高度)×(输入宽度)×(输入通道)。通过卷积层后,图像被抽象为一个特征图,也叫激活图,其形状为:(输入数)×(特征图高度)×(特征图宽度)×(特征图通道)。

卷积层对输入进行卷积,并将其结果传递给下一层。这类似于视觉皮层中的神经元对特定刺激的反应。每个卷积神经元只处理其接受区域的数据。虽然全连接的前馈神经网络可以用来学习特征和分类数据,但这种架构对于较大的输入,如高分辨率图像,通常是不切实际的。它需要非常多的神经元,即使是浅层架构,由于图像的输入尺寸很大,每个像素都是一个相关的输入特征。例如,一个尺寸为100×100的(小)图像的全连接层在第二层的每个神经元有10,000个权重。相反,卷积减少了自由参数的数量,使网络更加深入。例如,无论图像大小如何,使用5×5的平铺区域,每个共享权重相同,只需要25个可学习的参数。在较少的参数上使用正则化权重,可以避免梯度消失和扩大

内容由匿名用户提供,本内容不代表vibaike.com立场,内容投诉举报请联系vibaike.com客服。如若转载,请注明出处:https://vibaike.com/174473/