简介

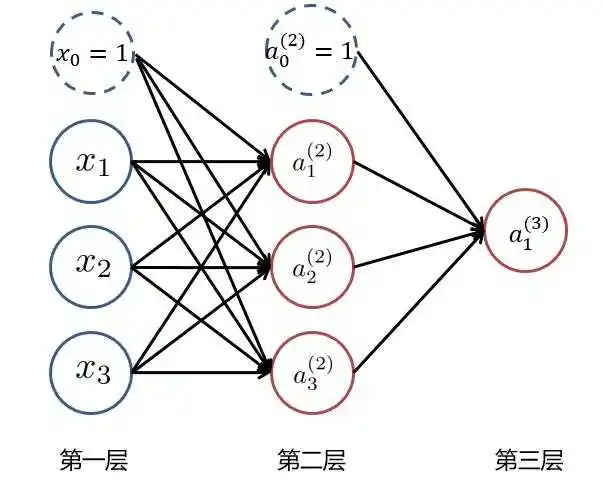

编辑人工神经网络是机器学习中使用的一类模型,其灵感来自生物神经网络。它们是现代深度学习算法的核心组成部分。人工神经网络的计算通常被组织成人工神经元的顺序层。一层中的神经元数量被称为层宽。

人工神经网络的理论分析有时会考虑层宽变大或无限的极限情况。这个极限使人们能够对神经网络的预测、训练动态、泛化和损失面做出简单的分析陈述。这种宽层极限也是有实际意义的,因为有限宽度的神经网络往往随着层宽的增加而有严格的表现。

基于大宽度极限的理论方法

编辑神经网络高斯过程(NNGP)对应于贝叶斯神经网络的无限宽度极限,也对应于非贝叶斯神经网络在随机初始化后实现的函数分布。

用于推导NNGP核的基础计算也被用于深度信息传播,以描述梯度和输入的信息通过深度网络的传播特征。

这个特征被用来预测模型的可训练性如何取决于架构和初始化超参数。神经切线核描述了梯度下降训练中神经网络预测的演变。

在无限宽度的限制下,NTK通常成为常数,通常允许在整个梯度下降训练过程中以闭合形式表达宽神经网络计算的函数。

对具有不同初始权重比例和适当大的学习率的无限宽度神经网络的研究导致了与固定神经正切核所描述的非线性训练动力学有质的不同。

Catapult动力学描述了在层宽达到无穷大时logits发散到无穷大的情况下的神经网络训练动力学,并描述了早期训练动力学的定性属性。

内容由匿名用户提供,本内容不代表vibaike.com立场,内容投诉举报请联系vibaike.com客服。如若转载,请注明出处:https://vibaike.com/175731/