神经网络高斯过程

编辑贝叶斯网络是一种建模工具,用于为事件分配概率,从而描述模型预测的不确定性。深度学习和人工神经网络是机器学习中用来建立计算模型的方法,这些模型从训练实例中学习。贝叶斯神经网络合并了这些领域。它们是一种人工神经网络,其参数和预测都是概率性的。虽然标准的人工神经网络经常对不正确的预测也赋予高置信度,但贝叶斯神经网络可以更准确地评估其预测的正确性。神经网络高斯过程(NNGPs)在一个特定的极限中等同于贝叶斯神经网络,并提供了一种封闭式的方法来评估贝叶斯神经网络。它们是一种高斯过程概率分布,描述了相应贝叶斯神经网络所做预测的分布。人工神经网络的计算通常被组织成人工神经元的顺序层。一层中的神经元数量被称为层宽。当贝叶斯神经网络中的层变得无限宽时,NNGP和贝叶斯神经网络之间的等价关系就出现了。这个大的宽度限制是有实际意义的,因为有限宽度的神经网络通常会随着层宽的增加而严格地表现得更好。NNGP还出现在其他几个场合:它描述了宽的非贝叶斯人工神经网络在随机初始化其参数后,但在训练前所做的预测的分布;它作为一个术语出现在神经切线核预测方程中;它被用于深度信息传播,以描述超参数和架构是否可训练。它与神经网络的其他大宽度极限有关。

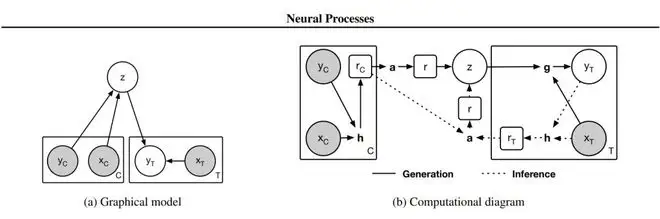

漫画说明

编辑每一个神经网络的参数设置{dISPlaystylep(theta)}对应于神经网络参数的先验分布p(θ)因此,关于神经网络参数的先验分布对应于由网络计算的函数的先验分布。由于神经网络是无限宽的,对于许多架构来说,这种对函数的分布会收敛为高斯过程。在参数空间中的分布,而黑点是这个分布的样本。对于无限宽的神经网络,由于神经网络计算的函数分布是一个高斯过程,对于任何有限的网络输入集合,网络输出的联合分布是一个多变量的高斯。本节中使用的符号与下文推导NNGP和全连接网络之间的对应关系时使用的符号相同,更多细节可在那里找到。

与NNGP对应的架构

编辑无限宽的贝叶斯神经网络和NNGP之间的等价关系已被证明适用于:单隐层和深度全连接网络,因为每层的单元数被认为是无限的;卷积神经网络,因为通道数被认为是无限的;变压器网络,因为注意头数被认为是无限的;递归网络,因为单元数被认为是无限的。事实上,这种NNGP对应关系几乎对任何架构都成立。

一般来说,如果一个架构可以完全通过矩阵乘法和协调非线性来表达(即张量程序),那么它就有一个无限宽的GP。这尤其包括所有由多层感知器、递归神经网络(如LSTM、GRU)、(nD或图)卷积、集合、跳过连接、注意、批量规范化和/或层规范化组成的前馈或递归神经网络。

内容由匿名用户提供,本内容不代表vibaike.com立场,内容投诉举报请联系vibaike.com客服。如若转载,请注明出处:https://vibaike.com/175852/