可分化的神经计算机

编辑在人工智能领域,可分化的神经计算机(DNC)是一种记忆增强的神经网络架构(MANN),它在实现上通常是(但不是定义上)递归的。该模型由DeepMind的AlexGraves等人在2016年发表。应用DNC间接地从Von-Neumann架构中获得灵感,使得它有可能在那些根本无法通过寻找决策边界来学习的算法任务中胜过传统架构。到目前为止,DNCs已经被证明只能处理相对简单的任务,这些任务可以用传统的编程来解决。但是,DNCs不需要为每个问题进行编程,而是可以进行训练。这种注意力允许用户按顺序输入复杂的数据结构,如图形,并在以后使用时回忆起来。此外,他们可以学习符号推理的各个方面,并将其应用于工作记忆。发表该方法的研究人员看到了这样的希望:DNCs可以被训练来执行复杂的结构化任务,并解决需要某种推理的大数据应用,如生成视频评论或语义文本分析。DNC可以被训练来导航快速交通系统,并将该网络应用于不同的系统。一个没有记忆的神经网络通常要从头开始学习每个交通系统。在有监督学习的图形遍历和序列处理任务上,DNC的表现比长短期记忆或神经图灵机等替代方案更好。用强化学习的方法解决一个由SHRDLU启发的块状拼图问题,DNC通过课程学习进行训练,并学会了制定计划。它的表现比传统的递归神经网络更好。

可分化的神经计算机的架构

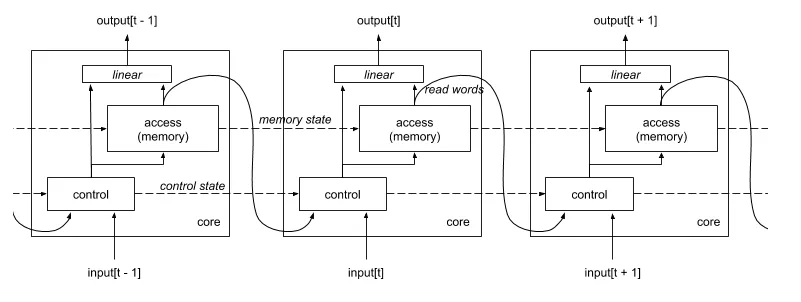

编辑DNC网络作为神经图灵机(NTM)的扩展被引入,增加了控制记忆存储位置的记忆注意机制,以及记录事件顺序的时间注意。这种结构使DNCs比NTM更加稳健和抽象,并且仍然可以执行比一些前辈如长短时记忆(LSTM)具有更长期依赖性的任务。记忆体是一个简单的矩阵,可以动态地分配和无限期地访问。DNC是可微分的端到端(模型的每个子组件都是可微分的,因此整个模型也是可微分的)。这使得使用梯度下降法对其进行有效优化成为可能。DNC模型类似于冯诺依曼架构,由于内存的可调整性,它是图灵完全的。

传统的DNC

编辑DNC,如最初发表的那样

可分化的神经计算机的扩展

编辑完善包括稀疏内存寻址,将时间和空间复杂性降低了数千倍。这可以通过使用近似近邻算法来实现,如位置敏感散列算法,或像UBC的近似近邻快速库那样的随机K-D树。添加自适应计算时间(ACT)将计算时间与数据时间分开,这利用了问题长度和问题难度不总是相同的事实。使用合成梯度的训练比通过时间的反向传播(BPTT)表现好得多。通过使用层规范化和BypassDropout作为规范化,可以提高鲁棒性。

内容由匿名用户提供,本内容不代表vibaike.com立场,内容投诉举报请联系vibaike.com客服。如若转载,请注明出处:https://vibaike.com/176852/