算法偏见

编辑算法偏见描述了计算机系统中的系统性和可重复的错误,这些错误造成了不公平的结果,例如以不同于算法预期功能的方式将一个类别置于另一个类别之上的特权。偏见可能来自许多因素,包括但不限于算法的设计或与数据编码、收集、选择或用于训练算法的方式有关的非故意或未预料的使用或决定。例如,在搜索引擎结果和社交媒体平台中已经观察到了算法的偏见。这种偏见可能会产生影响,从无意中侵犯隐私到强化种族、性别、性和民族的社会偏见。对算法偏见的研究最关注的是反映系统和不公平歧视的算法。这种偏见最近才在法律框架中得到解决,如欧盟的《通用数据保护条例》(2018年)和拟议的《人工智能法》(2021年)。随着算法扩大其组织社会、政治、机构和行为的能力,社会学家已经开始关注未预料到的数据输出和操纵可能影响物理世界的方式。因为算法通常被认为是中立和无偏见的,它们可以不准确地投射出比人类专业知识更大的权威(部分是由于自动化偏见的心理现象),在某些情况下,对算法的依赖可以取代人类对其结果的责任。由于预先存在的文化、社会或机构的期望,偏见可能会进入算法系统;由于其设计的技术限制;或者由于在未预料到的情况下被使用,或者被那些在软件最初设计时没有考虑到的受众使用。从选举结果到网上仇恨言论的传播,算法偏见已经被引用到各种案例中。它还出现在刑事司法、医疗保健和招聘中,加剧了现有的种族、社会经济和性别偏见。面部识别技术相对无法准确识别深色皮肤的脸,这与黑人男子多次被错误逮捕有关,这个问题源于不平衡的数据集。由于算法的专有性,在理解、研究和发现算法偏见方面的问题一直存在,这些算法通常被视为商业机密。即使提供了完全的透明度,某些算法的复杂性也对理解其功能构成了障碍。此外,算法可能会发生变化,或以无法预料的方式对输入或输出作出反应,或为分析而轻易复制。在许多情况下,即使在一个单一的网站或应用程序中,也没有单一的算法可供研究,而是由许多相互关联的程序和数据输入组成的网络,甚至在同一服务的用户之间。

算法偏见的定义

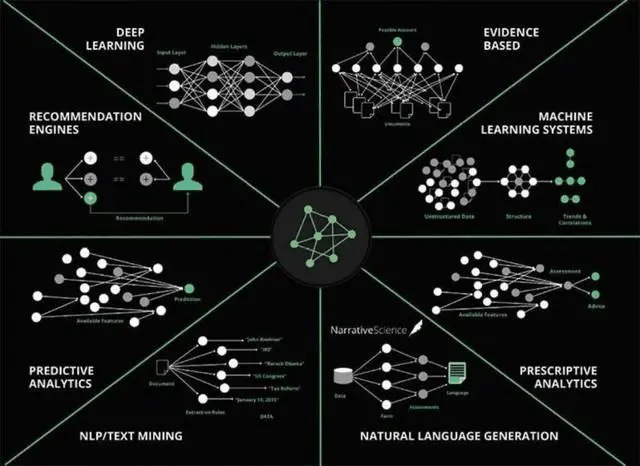

编辑算法很难定义,但一般可以理解为确定程序如何读取、收集、处理和分析数据以产生输出的指令列表。关于严格的技术介绍,见算法。计算机硬件的进步导致了处理、存储和传输数据的能力增强。这反过来又促进了机器学习和人工智能等技术的设计和采用。通过分析和处理数据,算法成为搜索引擎、社交媒体网站、推荐引擎、在线零售、在线广告等的骨干。当代社会科学家关注嵌入硬件和软件应用的算法过程,因为它们具有政治和社会影响,并质疑算法中立性的基本假设。

算法偏见这一术语描述了系统性和可重复的错误,这些错误造成了不公平的结果,例如使一个任意的用户群体比其他用户享有特权。例如,一个信用评分算法可以拒绝贷款,但并不公平,如果它一直在权衡相关的财务标准。如果该算法向一组用户推荐贷款,但根据不相关的标准拒绝向另一组几乎相同的用户提供贷款,并且如果这种行为可以在多次发生中重复,那么一个算法可以被描述为有偏见。这种偏见可能是有意的,也可能是无意的(例如,它可能来自于一个以前做过该算法现在要做的工作的工人所获得的有偏见的数据)。

算法偏见的方法

编辑偏见可以通过几种方式引入到算法中。在收集数据集的过程中,数据可能被收集、数字化、调整,并根据人类设计的编目标准输入数据库。接下来,程序员为程序如何评估和分类这些数据分配优先级,或称层次结构。这需要人类决定如何对数据进行分类,以及哪些数据被包括或丢弃。一些算法根据人类的选择来收集自己的数据。

内容由匿名用户提供,本内容不代表vibaike.com立场,内容投诉举报请联系vibaike.com客服。如若转载,请注明出处:https://vibaike.com/175445/